پژوهشگران اپل نسخهای اصلاحشده از مدل SlowFast-LLaVA را طراحی کردهاند که توانسته در حوزه تحلیل و درک ویدیوهای بلند عملکردی بهتر از مدلهای بسیار بزرگتر ارائه دهد. معنای این دستاورد در چند لایه فنی قابل بررسی است. در سادهترین توضیح، زمانی که یک مدل زبانی بزرگ برای درک ویدیو آموزش داده میشود، یاد میگیرد که ویدیوها را به فریمهای جداگانه تقسیم کند، از روشهای بینایی رایانهای برای استخراج ویژگیهای بصری استفاده کند، تغییرات این ویژگیها را در طول زمان تحلیل نماید و تمامی این دادهها را با زبان هماهنگ سازد تا در قالب متن بتواند درباره ویدیو توصیف کرده یا استدلال ارائه دهد.

یکی از روشهای بسیار ناکارآمد در این فرایند، تحلیل تکتک فریمهای یک ویدیو است. این شیوه حجم انبوهی از اطلاعات تکراری ایجاد میکند، زیرا در بسیاری از موارد، تفاوت میان یک فریم و فریم بعدی بسیار ناچیز است. چنین حجم عظیمی از دادههای تکراری بهراحتی میتواند از ظرفیت پنجره زمینه مدل زبانی فراتر رود؛ ظرفیتی که بیشینه اطلاعات قابل نگهداری همزمان توسط مدل را تعیین میکند. زمانی که مدل از این حد عبور کند، ناچار میشود برای ادامه پیشبینی توکنهای جدید، دادههای قدیمیتر را کنار بگذارد تا فضای کافی برای دادههای تازه فراهم شود.

البته روشهای بهینهتری برای آموزش مدلهای زبانی ویدیویی وجود دارند؛ برای نمونه انویدیا اخیراً مقالهای ارزشمند در این زمینه منتشر کرده است. اما برای درک تحقیق اپل کافی است این چارچوب کلی در ذهن باقی بماند. مطالعه اپل که در مقالهای با عنوان SlowFast-LLaVA-1.5: A Family of Token-Efficient Video Large Language Models for Long-Form Video Understanding منتشر شده، چنین توضیح میدهد: «مدلهای زبانی بزرگ ویدیویی، ادراک ویدیو را در مدلهای زبانی از پیش آموزشدیده ادغام میکنند تا بتوانند ویدیوها را پردازش کرده و به دستورات کاربر پاسخ دهند. با وجود پیشرفتهای قابل توجه، محدودیتهای آشکاری همچنان در مدلهای زبانی ویدیویی موجود باقی مانده است.»

به گفته پژوهشگران اپل، این محدودیتها سه دسته اصلی دارند:

مدلهای موجود به پنجرههای زمینه طولانی و تعداد بسیار زیاد فریمها وابستهاند که این امر ناکارآمد بوده و قابلیت انتقال به مدلهای کوچکتر را دشوار میسازد.اغلب آنها به مسیرهای آموزشی پیچیده و چندمرحلهای وابستهاند که معمولاً بر مجموعهدادههای اختصاصی تکیه میکنند و بازتولید آنها را دشوار میسازد.بسیاری از این مدلها صرفاً برای وظایف ویدیویی بهینه شدهاند و همین امر کاربری آنها را بهعنوان مدلهای همهمنظوره که توانایی درک تصاویر را نیز داشته باشند، محدود میکند.

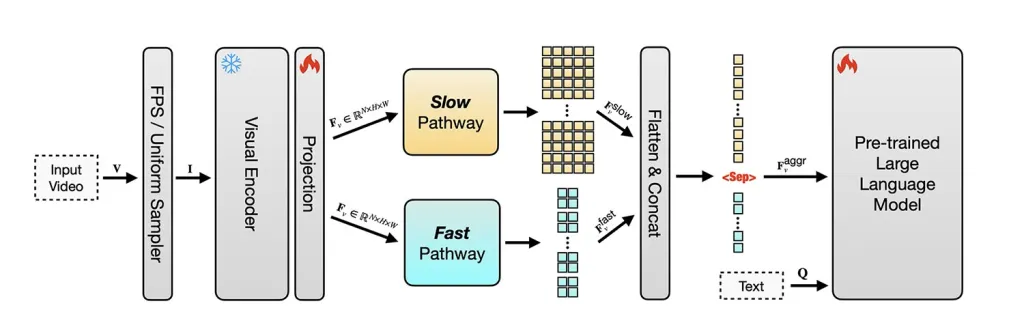

برای غلبه بر این محدودیتها، اپل ابتدا به سراغ مدل متنباز SlowFast-LLaVA رفت که پیشتر توانسته بود با بهرهگیری از نشانههای مکانی و زمانی از طریق یک معماری دوجریانی، نتایج امیدوارکنندهای کسب کند: یک جریان آهسته که تعداد کمتری فریم با جزئیات بالاتر بررسی میکند تا محتوای صحنه مشخص شود، و یک جریان سریع که تعداد بیشتری فریم با جزئیات کمتر تحلیل میکند تا حرکتها در طول زمان ردیابی شوند.

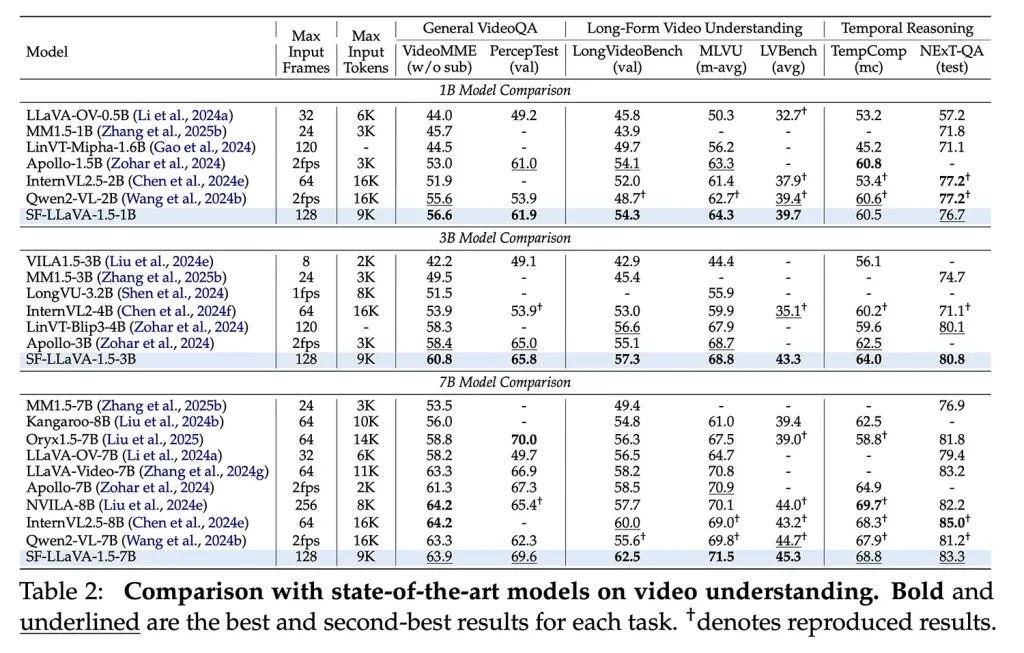

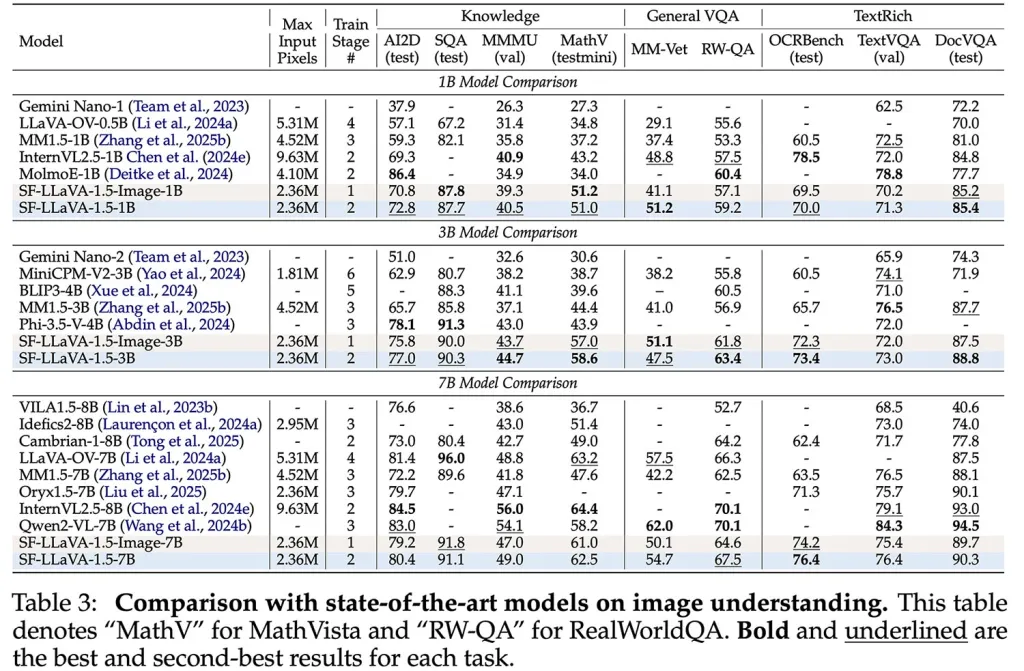

اپل نخست این مدل را روی تصاویر تنظیم دقیق کرد تا توانایی استدلال بصری عمومی ایجاد شود. سپس آن را بهصورت مشترک بر مجموعهای از تصاویر و ویدیوها آموزش داد تا ساختار زمانی را نیز بیاموزد، بدون آنکه توانایی درک تصاویر تضعیف شود. نتیجه این کار به تولد مدل SlowFast-LLaVA-1.5 یا به اختصار SF-LLaVA-1.5 منجر شد. این خانواده شامل مدلهایی با مقیاس 1B، 3B و 7B پارامتر است که در طیف گستردهای از وظایف ویدیویی توانستهاند عملکردی بهتر از مدلهای بسیار بزرگتر ارائه دهند، گاهی حتی با اختلاف قابل توجه.

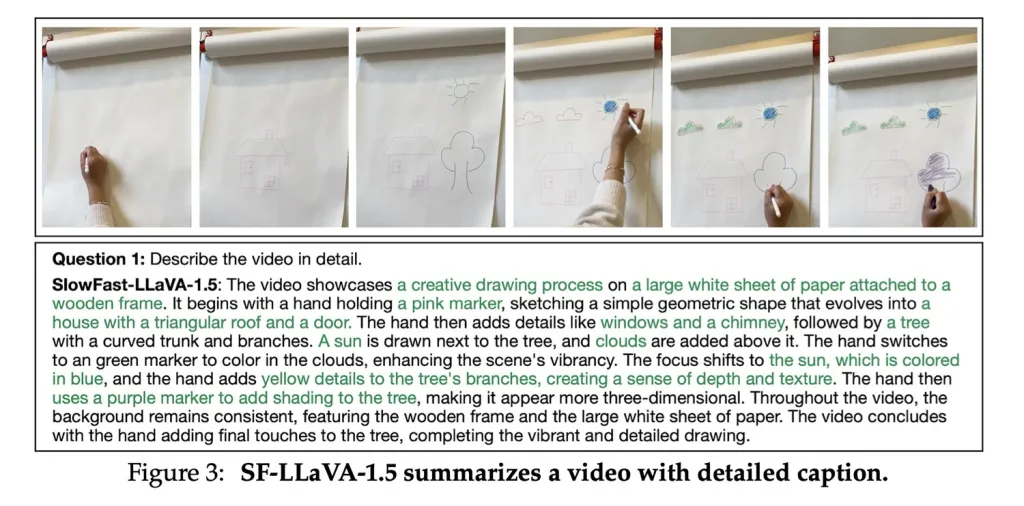

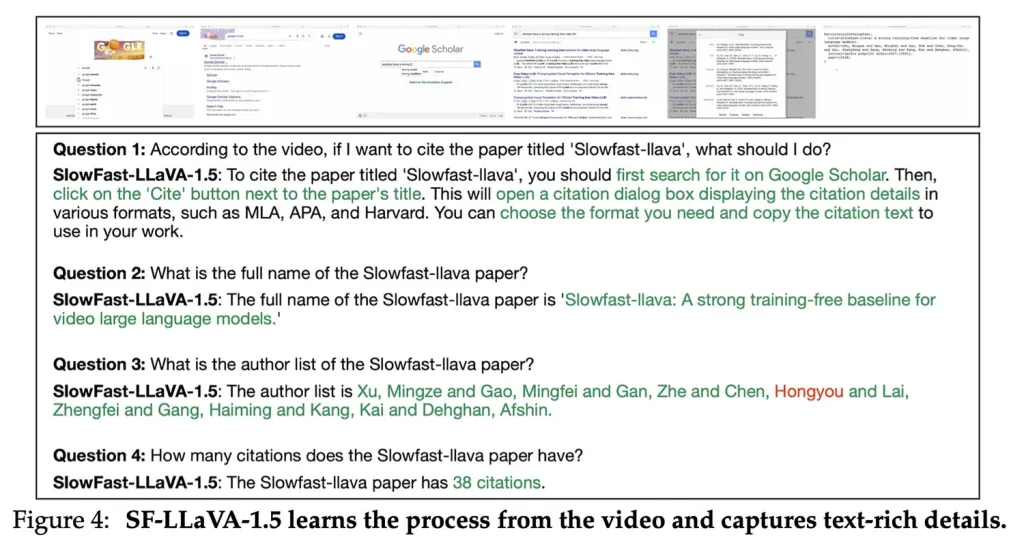

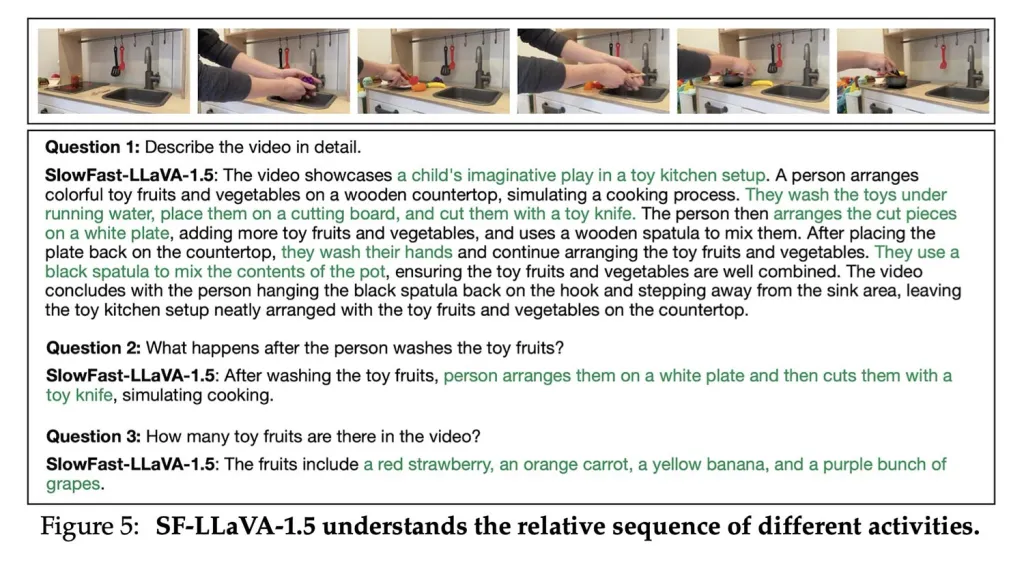

در واقع، در آزمونهای مرجع ویدیوی بلند مانند LongVideoBench و MLVU، مدل اپل توانست در تمامی اندازهها، حتی کوچکترین نسخه یعنی 1B، رکوردهای جدیدی را به ثبت برساند و بهعنوان بهترین مدل در این حوزه معرفی شود. علاوه بر آن، این مدل یکی از سه محدودیت ذکرشده را نیز پشت سر گذاشته و در وظایف مرتبط با تصویر هم کارایی مطلوبی نشان داده است؛ از جمله در آزمونهای مرتبط با دانش، استدلال ریاضی، OCR و سناریوهای متنی-بصری پیچیده. تیم پژوهش حتی چندین استراتژی فشردهسازی ویدیو را بررسی کرد، اما در نهایت دریافت که معماری پیشنهادی آنها بهترین توازن میان سرعت، دقت و تعداد توکنها را ایجاد میکند.

با این حال، محدودیتهایی همچنان وجود دارد. اپل تصمیم گرفت که در مدل SF-LLaVA-1.5 طول بیشینه ورودی فریمها برابر با ۱۲۸ فریم باشد. به این معنا که چه مدل بخواهد یک کلیپ چند دقیقهای یا چند ساعته را تحلیل کند، نهایتاً ۱۲۸ فریم پردازش میشود: ۹۶ فریم با فاصلههای یکنواخت برای جریان سریع و ۳۲ فریم با فاصلههای یکنواخت برای جریان آهسته انتخاب میشوند.

با توجه به این موضوع، پژوهشگران تصریح کردهاند: «این روش ممکن است برخی فریمهای کلیدی در ویدیوهای طولانی را از دست بدهد و مدل را درباره سرعت پخش ویدیو دچار خطا سازد. عملکرد SF-LLaVA-1.5 میتواند با تنظیم همه پارامترها، از جمله رمزگذار بصری، بهبود یابد. با این حال، به دلیل هزینه بالای حافظه GPU در ذخیره مقادیر فعالسازی، این کار برای مدلهای زبانی ویدیویی طولانی چندان ساده نیست. مطالعات آینده میتوانند به استفاده از تکنیکهای صرفهجویی حافظه، همچون Stochastic BP، بپردازند.»

با وجود این محدودیتها، رویکرد اپل مدلی در سطح پیشرفتهترین فناوریهای موجود ایجاد کرده که امتیاز ویژه آن آموزش صرفاً بر اساس مجموعهدادههای عمومی است. مدل SF-LLaVA-1.5 اکنون بهعنوان پروژهای متنباز در GitHub و Hugging Face در دسترس بوده و نسخه کامل مقاله نیز در arXiv منتشر شده است.